近日,哈尔滨工业大学张伟男教授及团队在SmartBot期刊发表了题为Embodied AI: A Survey on the Evolution from Perceptive to Behavioral Intelligence的综述文章,系统、全面地梳理了具身智能领域的研究现状与阶段性进展,并讨论关键挑战与未来方向。

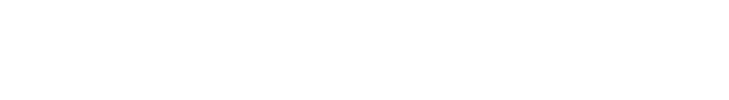

具身智能是指具有物理实体的智能体通过与现实环境的交互不断获得和发展智能的一种人工智能研究范式。在具体实践中,其核心研究对象主要集中于机器人与环境之间的交互行为。本文综述从机器人行为的角度出发,依据行为生成过程,将具身智能划分为三个核心模块:具身感知、具身决策与具身执行,并同时覆盖操作类与移动类两种典型机器人行为。整体研究框架如图1所示。

图1 具身智能整体框架图

具身感知关注具身智能体如何感受并理解周围环境,主要包括物体感知与场景感知两方面,分别对应于机器人操作与移动行为。物体感知涉及对物体几何形状、铰接结构及物理属性的识别与理解,可应用于物体抓取、铰接物体操作及精密操作等任务。场景感知则旨在构建尺度地图、拓扑图等多层次的场景模型,为机器人移动提供导航与规划支持。具身感知的研究范畴不仅包括面向机器人行为的感知(“感知用于行为”),还包括机器人行为如何增强感知(“行为用于感知”)。例如,机器人可以通过自主移动实现更好地建图和定位,通过操作微波炉探测其铰接结构。

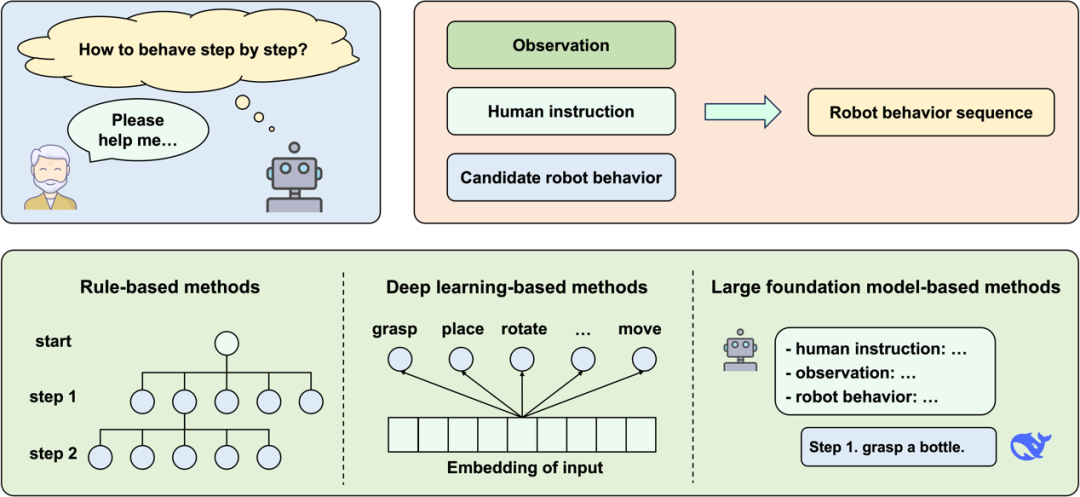

具身决策是指具身智能体在对环境进行观测和理解的基础上,从候选行为集合中推理并生成一条离散的行为序列,以完成既定的人类指令。按照行为类型的不同,具身决策可分为两类:其一是导航决策,如左转、右转、直行等移动指令;其二是任务规划,包括“拿取水瓶、打开冰箱”等具体操作技能,以及由移动与操作组合而成的复杂任务。与非具身决策(如工具使用学习)相比,具身决策的核心特征在于必须在真实物理环境中落地执行。例如,在抓取任务中,智能体不仅需要生成抓取动作,还需判断目标物体是否处于可达范围。近年来,基于大模型的方法逐渐成为具身决策的主流范式,但在任务规划过程中仍面临诸多挑战,例如输出结果往往非结构化、缺乏可执行性以及实际效用不足等问题。

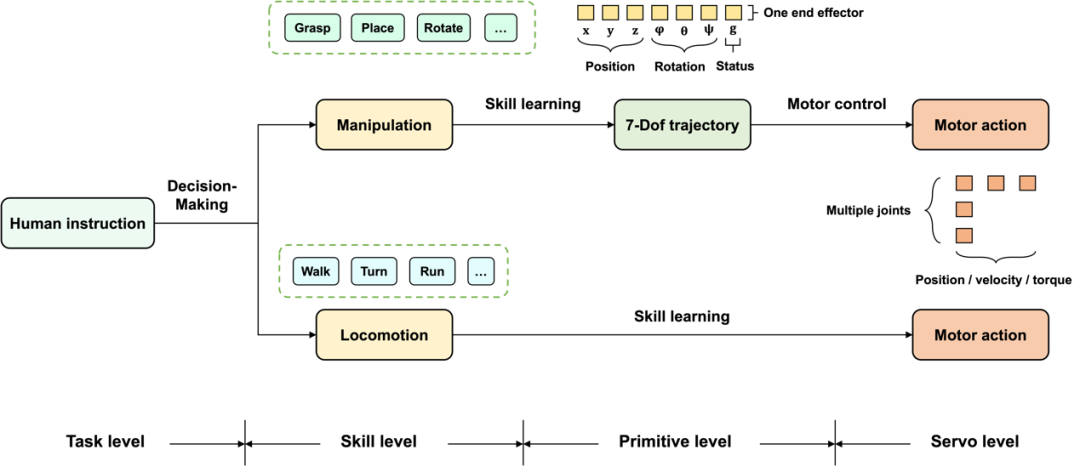

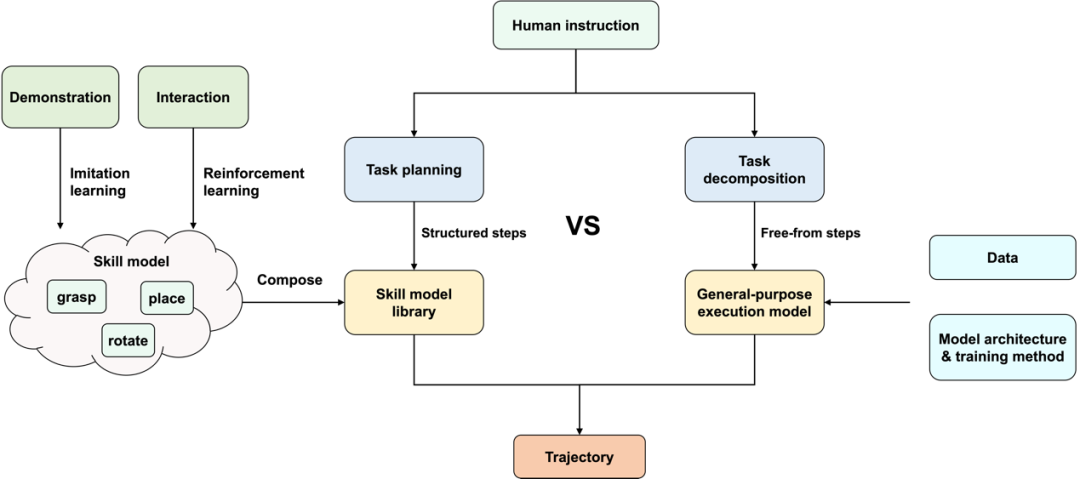

具身执行旨在学习机器人行为策略以指导机器人行动。其包括操作技能学习和运动(Locomotion)技能学习两部分,本综述重点关注操作技能学习。操作技能学习的主要方法包括模仿学习和强化学习两大类,其难点在于如何实现在物体、场景、技能、指令上的泛化性。经典的操作技能学习算法大多学习单个技能,并且需要从头开始训练。而通用执行模型可以基于单个模型完成多种技能,是具身执行的未来方向之一。但目前已有的通用执行模型在模型性能、泛化性上有所欠缺,仍需要在数据、模型结构及训练方法两方面进行改进。大规模、多样化、高质量的机器人操作数据是通用执行模型的基石,现有的数据来源主要包括大规模人工采集数据、自动构建数据以及无标注互联网数据。在模型结构和训练方法方面,目前的视觉-语言-动作模型主要采用自回归、扩散策略两种解码方法。

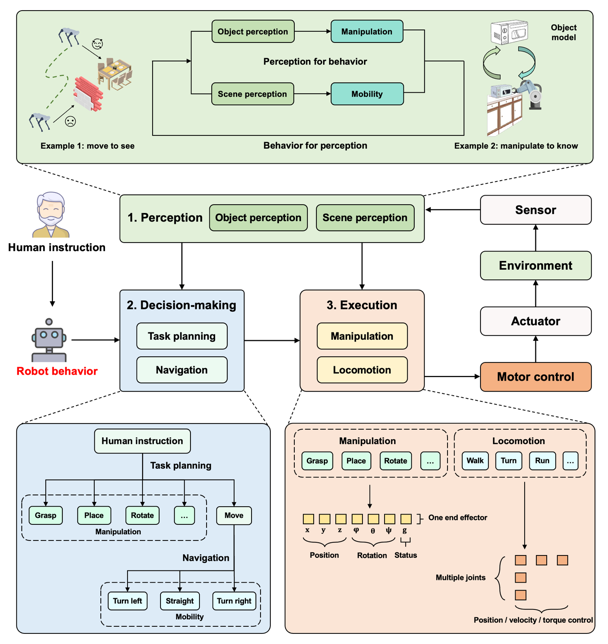

机器人智能行为的实现可以分为三个层次,如图2(a)所示,机器人本体是行为的硬件基础,包括传感器和执行器两部分。关节控制直接操控底层硬件完成给定的运动轨迹,使机器人具备行为能力。在最上层,具身智能基于人工智能技术,将抽象的人类指令转化为具体的运动轨迹,实现机器人智能行为。

图2 机器人行为概览

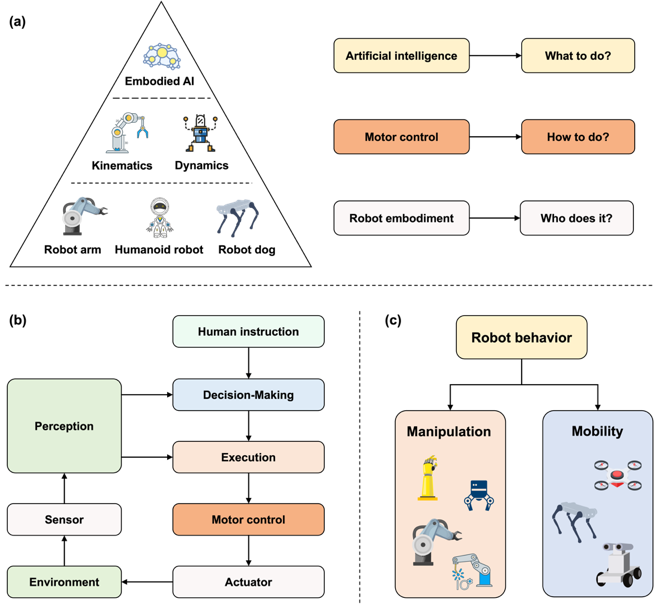

具身感知的重点在于,通过机器人行为增强感知效果。将机器人行为引入感知过程的好处在于:1)获取更多的信息;2)学习机器人行为与观察之间的因果关系。图3描述了机器人行为增强的物体感知。在这一过程中,给定当前物体模型和机器人动作,可以预测下一时间物体状态。给定机器人行为,以及预测的物体状态和真实行为后的物体状态,由此可以更新物体模型。基于前两个步骤,机器人可以通过交互的方式增强其对物体模型的理解。在第三步,给定物体模型,以及希望的物体状态,可以推理出机器人应该执行的动作,由此可以指导机器人与环境交互。

图3 机器人行为增强的物体感知

具身决策可以概括为两部分:1)将任务表示为标准的决策问题;2)在此基础上推理得到行为次序,如图4所示。具身决策问题的输入为人类指令、环境观察、机器人候选行为集合,输出为离散行为序列。具身决策的推理方法可以分为基于规则、基于深度学习、基于大模型三类。由于真实世界的复杂性,具身决策问题的表示与推理之间存在取舍。将问题输入使用符号化表示可以降低推理难度,但会导致信息损失。直接以原始信号作为输入更加接近真实情况,但推理难度更大。

图4 具身决策问题的表示与推理

具身执行旨在将高层次的人类指令转化为机器人可执行的具体运动轨迹。其过程如图5所示:人类指令首先经过具身决策模块,被分解为操作技能或运动技能。对于操作技能学习,系统会先生成中间层的七自由度轨迹,再通过关节控制器进一步转化为具体的关节动作;而在运动技能学习中,则可直接输出关节动作,从而实现指令到执行的快速映射。

图5 不同层次的机器人动作

实现机器人的通用操作能力有两种技术路线,如图6所示。第一种技术路线是构建操作技能库,为每个技能单独训练模型。第二种技术路线是构建通用执行模型,基于一个模型完成所有的操作技能。两种技术路线在决策、执行部分均存在差异。技能库的方式必须由任务规划显式地选取技能模型,并给出结构化的规划结果供程序解析。而通用执行模型则可以处理自由形式的规划步骤,无需显式地选取操作模型。由于人类指令的多样性和复杂性,技能库往往需要囊括大量技能,但这会导致任务规划难以选取合适的技能。通用执行模型的方式则不存在这一问题,并且多技能联合训练的方式更有可能在物体、场景、技能和指令维度实现更强的泛化性。我们认为,技能库的方式在现阶段更适合落地,而通用执行模型则代表操作技能学习的未来方向。

图6 技能库与通用执行模型两种技术路线对比

具身智能旨在借助人工智能技术赋予机器人智能化的行为能力。按照机器人行为的生成过程,具身智能可划分为三个核心模块:具身感知、具身决策与具身执行,每一模块又可依据操作类与移动类行为进一步细分。本文在此基础上提出了具身智能的研究框架,并系统梳理了相关任务、主流方法、未来发展方向及亟待解决的挑战。

具身智能领域面临诸多挑战。人工智能技术本质是一种数据驱动的方法,基于数据构建统计模型,而传统的机器人学研究是面向物理过程构建机理模型。两种范式存在较大的差别,由此带来的一个挑战是人工智能方法的不确定性,以及相应的安全性问题。引用阿西莫夫的机器人三定律,机器人需要优先确保人类的安全,以及在完成人类指令的过程中确保机器人本体的安全。

具身感知的难点在于,尽管大模型已成为2D视觉感知的主流范式,并逐步拓展至3D,但如何将其有效迁移到“以行为增强感知”的交互式场景仍有待探索。具身决策面临的挑战包括长序列规划成功率低、缺乏统一技能库等。在具身执行方面,通用执行模型是重要的未来方向,但面临数据需求大、推理速度慢、显存占用高等问题。

全文链接:https://doi.org/10.1002/smb2.70003

To cite this article:Yifan, Chen, Mingjie Wei, Xuesong Wang, et al. 2025. “ Embodied AI: A Survey on the Evolution from Perceptive to Behavioral Intelligence.” SmartBot: e70003. https://doi.org/10.1002/smb2.70003

作者简介

![]()

张伟男

哈尔滨工业大学长聘教授、博士生导师,国家级青年人才,人工智能学院执行院长兼计算学部副主任。主要从事具身智能、大模型、社交机器人等方向的研究。主持/参与国家重点研发计划青年科学家项目、国家自然科学基金重点项目、科技创新2030“新一代人工智能”重大项目;获得黑龙江省科技进步一等奖、中国人工智能学会吴文俊人工智能科技进步一等奖;担任黑龙江省中文信息处理重点实验室副主任、中国中文信息学会具身智能专委会(筹)主任、中国中文信息学会社交媒体处理专委会社交机器人专业组组长等职务。